Architettura di un Agente AI

📄 Questo articolo è un estratto del documento completo

“Agenti AI: Prospettive, Sfide e Architetture per un Futuro Inclusivo e Sostenibile”, che puoi leggere e scaricare liberamente in fondo alla pagina.

✉️ Se ti va, registrati gratuitamente: così potremo rimanere in contatto e aggiornarti su nuovi contenuti e iniziative!

Una visione a più livelli

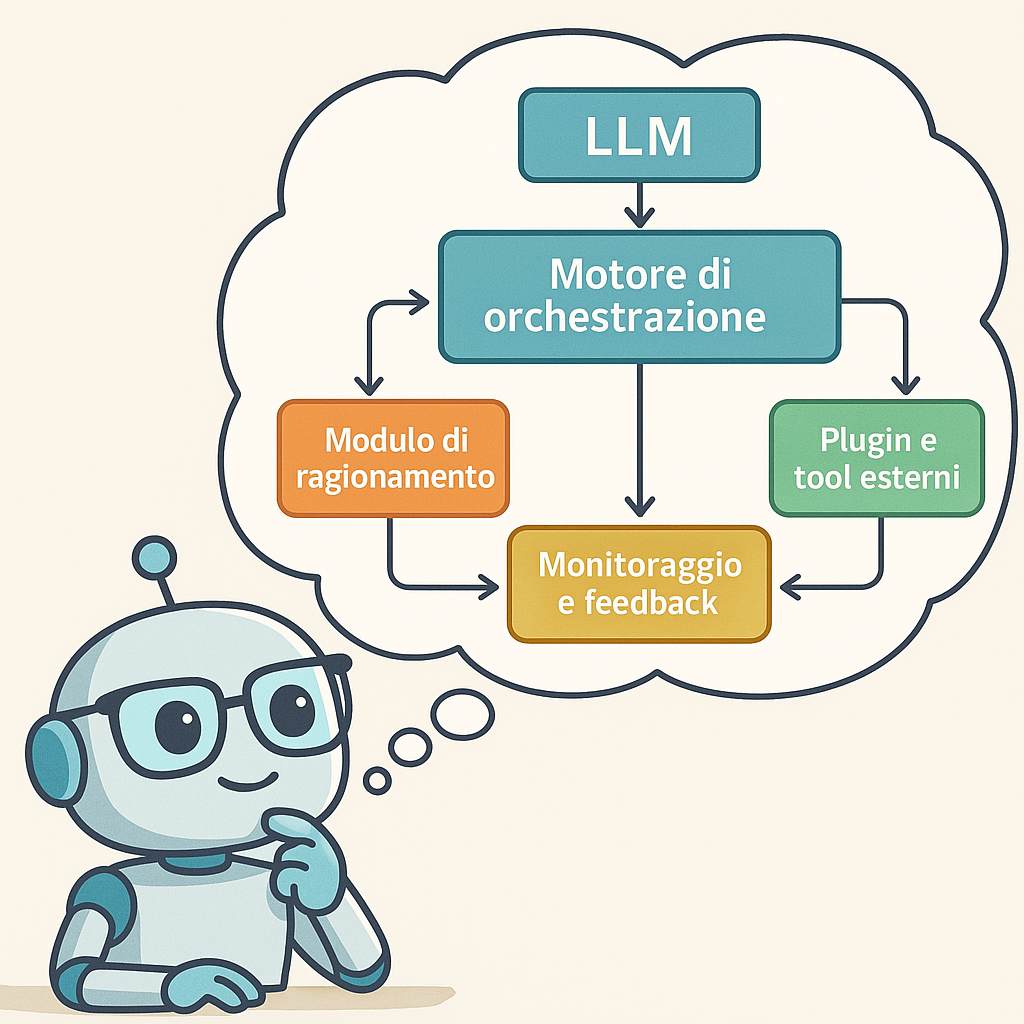

Gli Agenti AI non si limitano a “chiamare un modello” per generare testo, ma si compongono di più moduli che cooperano fra loro. L’idea chiave è coordinare il potere semantico dei modelli di linguaggio (LLM) con altri sistemi specializzati: banche dati, API, sensori IoT, ecc.

Ecco i principali blocchi funzionali:

- Modello di linguaggio (LLM): È il nucleo semantico: elabora il testo e risponde alle richieste in linguaggio naturale. Esempi: GPT, Claude, Mistral. Grazie a un prompt ben strutturato, è possibile “guidare” il LLM verso obiettivi specifici (ad es. supporto clienti, reportistica, analisi predittive).

- Motore di orchestrazione: Coordina il flusso di lavoro dell’agente, smistando le richieste fra i vari sottosistemi. Ad esempio, se l’utente chiede di estrarre dati da un database e poi sintetizzarli in un report, il motore di orchestrazione decide quali passi eseguire in sequenza e quali tool o plugin attivare.

- Modulo di ragionamento: Serve per affrontare task più complessi, che richiedono pianificazione o decision-making multi-step. Può basarsi su una IA simbolica, su logiche formali o su un mix di regole e reti neurali. In molti casi, è il LLM stesso a fungere da “motore di ragionamento”, ma in scenari critici (es. finanza, sanità) è frequente integrare logiche più trasparenti o verificabili.

- Plugin e tool esterni: Gli Agenti AI si collegano a servizi o strumenti esterni tramite API, come CRM, sistemi ERP, applicazioni di traduzione o funzioni specializzate (es. calcolo di statistiche). L’LLM può generare istruzioni per questi plugin, ampliando enormemente le proprie capacità: non solo risposte testuali, ma anche azioni reali sui dati o sui processi aziendali.

- Monitoraggio e feedback: È fondamentale registrare l’operato dell’agente e valutarne la qualità, in particolare quando ci sono vincoli di sicurezza, privacy o responsabilità legale.

Il monitoraggio continuo consente di “allenare” l’agente a ridurre errori, bias o allucinazioni, migliorando le performance nel tempo.

Perché è cruciale conoscerne l’architettura?

Capire come è strutturato un Agente AI aiuta a:

- Personalizzare il sistema in base alle esigenze: se vuoi un assistente per email automatiche, ti basta un LLM con un plugin di gestione posta; per analisi complesse, potresti integrare un modulo di ragionamento avanzato.

- Valutare rischi e investimenti: ogni componente (dalle GPU ai plugin esterni) incide su costi, consumi e sicurezza. Una scelta ben ponderata evita sprechi e vulnerabilità.

- Evolvere nel tempo: modificando i prompt, aggiungendo nuovi tool o aggiornando l’LLM, puoi adattare l’agente a scenari sempre diversi, senza riscrivere tutto da zero.

Conclusioni

Un Agente AI è, di fatto, un ecosistema dinamico in cui il modello di linguaggio lavora fianco a fianco con strumenti specializzati, coordinato da un motore di orchestrazione e arricchito da logiche di ragionamento. Questa “intelligenza connessa” consente alle aziende di automatizzare attività complesse, ridurre gli errori operativi e liberare risorse umane per compiti più strategici.

Se vuoi approfondire l’argomento e scoprire come sfruttare al meglio gli Agenti AI, scarica qui il PDF integrale e seguimi per i prossimi articoli, in cui parleremo di benefici, protocolli di colloquio e tanto altro.